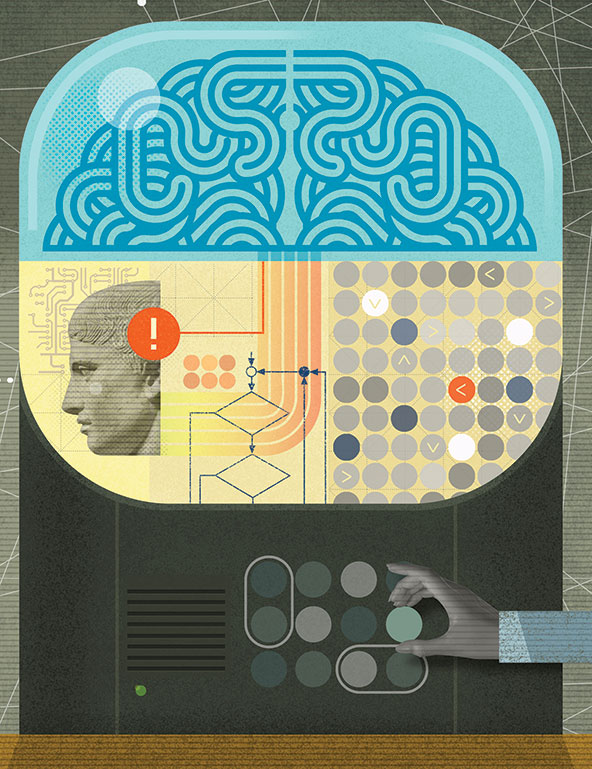

Grande parte da inteligência artificial (IA) utilizada hoje é dedicada a prever o comportamento das pessoas. Adivinhar qual será sua próxima compra, seu próximo clique do mouse, sua próxima decisão de trabalho, por exemplo. Mas tais técnicas podem ser problemáticas quando usadas para analisar dados referentes a programas de saúde e desenvolvimento. Sem saber as causas subjacentes aos comportamentos, corremos grande risco de tomar más decisões e apoiar políticas ineficazes e deletérias.

A IA, por exemplo, permitiu aos sistemas de saúde prever quais pacientes têm maior probabilidade de precisar de atendimentos médicos mais complexos. Nos Estados Unidos, um software de previsão de risco está sendo aplicado a cerca de 200 milhões de pessoas para detectar os pacientes com maior risco que deveriam ter acompanhamento extensivo no presente, com base em seu provável custo futuro ao sistema de saúde. O software emprega aprendizado de máquina preditivo, um conjunto de algoritmos autoadaptativos cuja precisão aumenta à medida que é alimentado com novos dados. Entretanto, como demonstraram o pesquisador em saúde Ziad Obermeyer e seus colegas num artigo publicado recentemente na revista Science, essa ferramenta em particular teve um resultado indesejado: ela não apontou a necessidade de atendimento extra para pacientes negros com mais doenças crônicas que os brancos.

O que deu errado? O algoritmo usou dados de pedidos de reembolso a convênios médicos para prever as necessidades futuras de atendimento dos pacientes com base nos custos de seus atendimentos recentes. Mas os criadores do algoritmo não levaram em conta que as despesas médicas dos negros nos Estados Unidos são tipicamente inferiores às dos brancos em condições de saúde equivalentes, por razões não relacionadas à presença ou não de doenças – tais como barreiras ao acesso à saúde, atendimento inadequado ou ausência de convênio. A utilização de despesas médicas como indicativas de doença levou o algoritmo preditivo a fazer recomendações que eram corretas no caso de pacientes brancos – menores despesas médicas eram consequência de menor incidência de problemas de saúde –, mas perpetuou distorções raciais no caso dos pacientes negros. Os pesquisadores notificaram o desenvolvedor, que fez testes utilizando dados próprios, confirmou o problema e colaborou com os pesquisadores para eliminar a distorção algorítmica.

Essa história demonstra um dos riscos de certos tipos de IA. Por mais sofisticados que sejam, os algoritmos preditivos e seus usuários podem cair na armadilha de confundir correlação e causa – em outras palavras, de presumir que, se o evento X precede o evento Y, o evento X deve ser a causa do evento Y. Um modelo preditivo é útil para se estabelecer a correlação entre um evento e um resultado. Segundo o modelo, “Quando observamos X, podemos prever que Y vai ocorrer”, mas isso não prova que Y ocorre por causa de X. No caso do algoritmo de atendimento médico, maiores incidências de doenças (X) foram corretamente relacionadas a despesas médicas mais altas (Y) para pacientes brancos. X causava Y, logo era possível usar as despesas médicas como preditoras de doença e necessidade de atendimento no futuro. Porém, no caso de pacientes negros, uma maior incidência de doenças em geral não levava a despesas maiores, e o algoritmo não previa a necessidade futura de atendimento com precisão. Havia correlação, mas não causalidade.

Esse dado é relevante num momento em que, cada vez mais, o mundo recorre à inteligência artificial para ajudar a enfrentar questões urgentes de saúde e desenvolvimento. O uso exclusivo de modelos de IA preditiva em setores tão diferentes como saúde, justiça e agricultura pode ter consequências devastadoras quando se confunde correlação com causalidade. Por isso, é essencial que tomadores de decisão também levem em consideração outro tipo de IA – a IA causal, que pode ajudar a identificar relações precisas de causa e efeito. A identificação das causas primárias de determinados resultados não é a única vantagem da IA causal; ela também permite que se simulem intervenções capazes de alterar esses resultados, usando algoritmos de IA causal para fazer perguntas do tipo “e se”. Por exemplo, se um programa específico de aprimoramento de professores é implementado, qual é o aumento que podemos esperar nas notas dos alunos nas provas de matemática? O uso de simulações para avaliar e comparar o efeito potencial de uma intervenção (ou conjunto de intervenções) sobre seu resultado economiza o tempo e o dinheiro que seriam gastos em longos testes de campo.

É certo que os algoritmos de IA preditiva têm papel importante, se aplicados e utilizados corretamente. Um bom exemplo é a agricultura de precisão (AP), que emprega inteligência artificial preditiva no processamento de imagens de satélite e dados de sensores para ajudar agricultores a prever o rendimento das safras, detectar doenças ou pragas e reconhecer diferentes espécies de plantas. Mas a capacidade de antever um resultado não implica a compreensão de sua verdadeira causa. Antecipar que a colheita de um agricultor será menor este ano é uma coisa; entender o porquê permite que sejam tomadas medidas para aumentar a produção.

Outro problema da utilização exclusiva de modelos preditivos é que, em essência, não se sabe por que eles fazem determinadas previsões. Esse é um problema do deep learning – o tipo de IA preditiva utilizado na AP. O deep learning é inspirado no modo como as células cerebrais humanas se organizam (em “camadas”) e se comunicam (recebendo sinais emitidos pelas células de uma camada, transformando esses sinais e emitindo os sinais alterados para as células de outra camada). Diferentemente de métodos em geral usados para prever resultados – como a regressão, uma técnica estatística tradicional que mapeia as relações entre variáveis e o resultado previsto com base em uma fórmula matemática ideal –, o deep learning é capaz de mapear variáveis e resultados com interrelações muito mais complexas. Os algoritmos de deep learning combinam diversas camadas de variáveis de entrada e saída e, por isso, são capazes de aprender relações entrada-saída muito mais complexas que uma única fórmula matemática e utilizá-las para prever resultados. No entanto, as ligações e os intermediários entre as variáveis são armazenados numa “caixa-preta”; por isso, os usuários – e até os criadores – dos algoritmos não conseguem discernir facilmente as relações entre as variáveis, ou entre as variáveis e o resultado. Isso quer dizer que, em muitos casos, é impossível saber quais funções de entrada foram utilizadas por modelos de deep learning para fazer suas previsões.

Essa opacidade é inaceitável quando se está lidando com a trajetória de vida das pessoas, como no sistema de justiça criminal dos Estados Unidos. Em 2016, 2,3 milhões de americanos adultos, ou um em cada 111, estavam na prisão, a um grande custo para os governos estaduais e federal. Os tribunais do país introduziram “notas de reincidência”, numa tentativa de diminuir os custos de encarceramento reduzindo a quantidade de detentos sem que isso aumentasse a criminalidade. A nota de reincidência é um número obtido por meio de um algoritmo preditivo que estima a probabilidade de que uma pessoa condenada venha a cometer outro crime. Em tese, a nota permite que um juiz se concentre em prender aqueles com maior probabilidade de cometer novos crimes, e deve até mesmo ajudar a eliminar potenciais distorções nas sentenças. Mas as notas de reincidência são inerentemente problemáticas, porque se baseiam em ferramentas de avaliação de riscos que detectam correlações estatísticas, e não fatores causais. Por exemplo, a baixa renda está correlacionada ao crime, mas isso não significa que seja a causa do crime. No entanto, pessoas de domicílios de baixa renda podem automaticamente receber uma nota de reincidência alta, e por isso é mais provável que sejam condenadas à prisão. Para corrigir o sistema de justiça criminal, é preciso procurar compreender as causas do crime, e não apenas suas correlações.

Um olhar mais atento à inteligência artificial causal vai demonstrar como ela pode abrir a caixa-preta dentro da qual os modelos puramente preditivos de IA operam. A IA causal pode ir além da correlação, apontando relações precisas entre causas e efeitos.

Estudos Randomizados Controlados

A importância de se testar a causalidade nos setores de saúde e desenvolvimento não é novidade. Um modo simples de fazê-lo é intervindo em pessoas aleatoriamente incluídas num grupo populacional, conhecido como grupo tratamento, e não intervindo num grupo idêntico, conhecido como grupo controle. Comparando-se os resultados entre os dois grupos, é possível isolar o efeito da intervenção. Em estudos clínicos, esse tipo de estudo chama-se estudo randomizado controlado, e em pesquisa de marketing chama-se teste A/B.

Os economistas desenvolvimentistas Michael Kremer, Abhijit Banerjee e Esther Duflo ganharam o Prêmio Nobel de Economia em 2019 por liderarem a aplicação de estudos randomizados controlados para identificar as causas primárias de problemas de desenvolvimento e criar soluções. Esses estudos contrariaram parte do senso comum acerca da causalidade. Por exemplo, diversos estudos observacionais haviam identificado associações entre a deficiência de vitamina D e maior risco de diabetes, hipertensão, doença cardiovascular e câncer. Porém, estudos randomizados controlados demonstraram que suplementos de vitamina D não reduzem o risco de contrair essas doenças – os estudos não encontraram relação causal entre os suplementos de vitamina D e resultados em saúde.

Entretanto, os estudos randomizados controlados têm limitações. É preciso trabalhar com grandes grupos de indivíduos para garantir que os resultados não sejam distorcidos ou afetados por características secundárias coincidentes, como idade, gênero, condições de saúde ou grau de instrução. Isso tende a fazer com que sejam extremamente custosos (na ordem de milhões de dólares) e demorados (podendo levar anos). Além disso, esses estudos só podem testar o efeito de uma ou, no máximo, algumas intervenções conjuntas por vez, embora os resultados sociais e de saúde sejam complexos, com diversos fatores subjacentes. Por fim, esses estudos só conseguem prever se uma intervenção surtirá determinado efeito sobre um membro típico do grupo de tratamento, e não sobre um indivíduo específico.

É aí que entra a IA causal. Ela oferece novas oportunidades de se testar a causalidade em indivíduos e grupos populacionais com maior rapidez e eficácia, bem como a capacidade de desvendar a complexidade subjacente. Ela permite a pesquisadores e desenvolvedores de programas simular uma intervenção e inferir a causalidade com base em dados já disponíveis.

Dois Modelos para Descobrir a Causalidade

Há dois tipos de modelo de IA causal baseados em princípios há muito conhecidos: o modelo de resultados potenciais e os modelos gráficos causais. Ambos permitem que se testem os efeitos de uma intervenção em potencial utilizando dados do mundo real. Eles fazem jus ao nome “IA” devido aos poderosos algoritmos subjacentes empregados para revelar padrões causais em grandes conjuntos de dados. Porém, diferem na quantidade de causas potenciais que são capazes de testar.

Para entender os dois métodos e seu funcionamento – bem como as diferenças entre eles –, considere o seguinte cenário hipotético: pesquisadores queriam descobrir se uma campanha publicitária antifumo havia convencido pessoas a parar de fumar, mas não havia grupo de controle, porque os anúncios haviam sido veiculados nacionalmente. Só existia um conjunto de dados, que informava se os indivíduos tinham sido expostos aos anúncios, se tinham parado de fumar, quais eram seus perfis demográficos e outros comportamentos relativos à saúde. Mesmo sem grupo de controle, a IA causal permite que se infira causalidade.

O modelo de resultados potenciais, proposto pelos estatísticos Paul Rosenbaum e Donald Rubin em 1983, compara o resultado (parar de fumar) de uma pessoa exposta à causa de interesse (o anúncio antifumo) a um “resultado potencial” inferido para o mesma pessoa caso ela não tivesse sido exposta. O desafio, evidentemente, é que não há dados referentes a resultados no caso de não exposição para pessoas que de fato tenham sido expostas à campanha. Assim, para cada indivíduo exposto ao anúncio, os algoritmos de IA encontram um outro indivíduo no conjunto de dados que não tenha sido exposto ao anúncio, mas que seja idêntico em outros aspectos significativos (como idade, raça e grau de instrução). Em outras palavras, um grupo controle artificial é criado por engenharia reversa para simular um estudo randomizado controlado. A limitação desse método é que, embora o modelo de resultados potenciais seja capaz de solucionar o problema da ausência de um grupo controle, ele consegue testar o efeito de uma intervenção predefinida por vez – nesse caso, se a campanha publicitária foi responsável pela decisão da pessoa de parar de fumar.

Por outro lado, os modelos gráficos causais conseguem mais que testar a relação de causa e efeito em um único par de variáveis. Eles podem ser usados como ferramentas exploratórias para mapear todos os diferentes caminhos causais até um resultado de interesse e para revelar as relações entre diferentes variáveis. Se aplicarmos um gráfico causal à nossa campanha antifumo, ele poderá demonstrar que a exposição ao anúncio numa farmácia levou algumas pessoas diretamente a parar de fumar e outras a comprar adesivos de nicotina que, por sua vez, as fizeram interromper o hábito.

Existem diversos modelos gráficos causais. Um método bastante utilizado é o modelo de equação estrutural, no qual pesquisadores especificam as variáveis que podem interagir e de que modo, e então o modelo analisa os dados para revelar se elas de fato interagem. Embora consiga testar muitas relações desse tipo entre os dados, nesse modelo toda a rede de interação entre diferentes variáveis precisa ser especificada utilizando conhecimentos existentes. Sua limitação está no fato de que ele só testa conexões entre as variáveis incluídas na hipótese: se as variáveis causadoras do resultado não forem especificadas, elas não serão avaliadas em relação às demais opções.

Outro método gráfico causal é a rede causal bayesiana, termo criado na década de 1980 pelo cientista da computação e filósofo Judea Pearl em alusão ao estatístico inglês do século 18 Thomas Bayes. Esse método estima as relações entre todas as variáveis num conjunto de dados. Seu resultado é um mapa visual intuitivo que demonstra quais variáveis influenciam umas às outras, bem como o grau dessa influência. A vantagem desse método é que, diferentemente do que ocorre no modelo de equação estrutural, essas interações não precisam ser especificadas antes da realização do teste, o que faz dele um método real de descoberta.

Embora as redes causais bayesianas precisem de dados em abundância para retratar um universo de variáveis possíveis, o método é promissor por diversos motivos. Ele permite a descoberta concomitante de diversas relações causais com base em dados. No exemplo da campanha antifumo, uma rede causal bayesiana poderia demonstrar como a propaganda e a disponibilidade de diferentes produtos para parar de fumar afetaram o comportamento das pessoas, ou revelar o papel desempenhado pelas aspirações pessoais. Ao contrário da caixa-preta da IA preditiva, no método da IA causal, as relações entre as variáveis (exposição a anúncios, disponibilidade de adesivos de nicotina) ficam visíveis aos pesquisadores, implementadores do programa e formuladores de políticas.

Os modelos gráficos causais também permitem que se simulem diversas intervenções possíveis simultaneamente. Por exemplo: e se diferentes anúncios antifumo fossem dirigidos a faixas etárias distintas, ou se houvesse uma campanha generalizada em conjunto com ações de educadores da própria comunidade? Esses modelos também permitem que se utilize o conhecimento de especialistas para contornar as possíveis limitações de um método exclusivamente baseado em processamento de dados. Por exemplo, especialistas não só podem contribuir para determinar que variáveis devem ser incluídas no modelo, mas colocar condições para aumentar a eficácia do modelo e ajudar a entender resultados contraintuitivos.

Aplicação Efetiva

O campo da IA causal está evoluindo rapidamente. Seu potencial é cada vez mais evidente, e pesquisadores a estão adotando em setores tão diversos quanto mudanças climáticas e saúde.

Mudanças climáticas | Técnicas de IA causal foram aplicadas às mudanças climáticas para entender se e como os seres humanos são uma de suas causas e o que determina as crenças das pessoas sobre o tema. Para investigar essa questão, cientistas britânicos usaram uma técnica de IA causal chamada atribuição contrafactual de eventos, no âmbito do modelo de resultados potenciais, para determinar se as emissões de gases do efeito estufa produzidos por seres humanos eram uma causa subjacente à onda letal de calor na Europa em 2003, que, segundo algumas estimativas, foi responsável por mais de 70 mil mortes. Utilizando dados históricos, dados solares, informações sobre erupções vulcânicas e dados atmosféricos sobre gases do efeito estufa, aerossóis e ozônio, os pesquisadores simularam temperaturas de verão por toda a Europa em 2003, com e sem impacto humano. Eles descobriram que a ocorrência da onda de calor era muito mais provável quando o modelo incluía atividades como viagens aéreas ou geração de energia elétrica que quando esses efeitos eram excluídos. O estudo, publicado em 2004, foi um dos primeiros a relacionar um evento climático extremo à atividade humana e forneceu um argumento poderoso para a redução nas emissões de gases do efeito estufa gerados por essas atividades. Ele foi citado no Painel Intergovernamental sobre Mudanças Climáticas das Nações Unidas.

A IA causal também identificou os fatores que levam as pessoas a adotar crenças mais polarizadas com relação às mudanças do clima. Pesquisadores entrevistaram participantes nos Estados Unidos e na Austrália e utilizaram redes bayesianas para criar um modelo de como diferentes pessoas reagiam a diferentes tipos de mensagem sobre as mudanças climáticas. Eles descobriram que quando informações consensualmente aceitas sobre mudanças climáticas foram apresentadas numa pesquisa on-line, norte-americanos que desconfiavam ativamente dos cientistas climáticos reagiram modificando suas crenças no sentido oposto ao das informações recebidas. Esse modelo causal forneceu uma nova maneira de se estimar as relações interconectadas entre visões de mundo, crenças científicas e confiança na ciência. Descobertas como essa são importantes para moldar as percepções do público acerca da necessidade de ações de combate às mudanças climáticas. Esses resultados podem ser usados na criação de mensagens de intervenção que levem em conta a provável reação dos participantes às informações, com base em suas crenças e históricos.

Diarreia infantil | A IA causal é capaz de lidar com problemas de saúde comuns e complexos que outros métodos não conseguiram solucionar. A diarreia infantil, segunda maior causa de morte no mundo entre menores de cinco anos, é um deles. Diversos fatores estão associados a ela, mas é extremamente difícil desvendar os caminhos causais, tanto biológicos quanto estruturais, das doenças diarreicas. Por esse motivo, é difícil criar intervenções eficazes.

Um estudo no Paquistão utilizou dados de uma pesquisa nacional com mais de 110 mil indivíduos de mais de 15 mil domicílios. A pesquisa cobriu variáveis domiciliares, sociais, ambientais e econômicas. Empregando regressão multivariada, uma técnica estatística tradicional, os pesquisadores encontraram 12 variáveis domiciliares significativamente associadas à diarreia. No entanto, essas variáveis eram de difícil interpretação: por exemplo, uma delas era a quantidade de quartos no domicílio. Por outro lado, uma análise do mesmo conjunto de dados por rede causal bayesiana gerou um mapa em rede, revelando três variáveis que influenciavam diretamente na incidência de doenças diarreicas em crianças: utilização de latrinas de fossa seca em vez de vasos sanitários com tubulação; utilização de água não encanada ou proveniente de rio ou corpo d’água; e ausência de coleta formal de lixo. Se incorporadas socialmente ou por meio de políticas nacionais, essas descobertas poderiam resultar em intervenções eficazes na redução das doenças diarreicas infantis.

Mortalidade materna e infantil | As taxas de mortalidade materna e infantil ainda são altas em muitos países de baixa renda. O parto em instituições de saúde pública é essencial para a sobrevivência e o bem-estar de mães e filhos. Por meio de um programa nacional de incentivo que paga famílias para que tenham seus bebês em instituições de saúde (300 rúpias indianas [cerca de 22 reais] pelo parto no hospital e mais 300 rúpias caso a mãe tenha utilizado cuidados pré-natais), o governo da Índia conseguiu melhorar rapidamente a taxa de partos institucionais. Contudo, em muitos estados indianos, essa tendência estacionou em cerca de 80%.

Na Surgo Foundation, tentamos entender por que as mulheres não estavam optando pelo parto institucional e que outras intervenções eram necessárias para convencê-las a fazê-lo. Usamos diversas técnicas, inclusive IA causal, para descobrir por que algumas famílias ainda optam pelo parto em casa. No estado de Uttar Pradesh, com mais de 230 milhões de habitantes, realizamos várias pesquisas quantitativas em larga escala para mensurar uma grande quantidade de possíveis fatores indutores do parto institucional. Em seguida, utilizamos uma rede causal bayesiana para determinar as variáveis que motivavam o comportamento e identificar quais delas seriam os alvos mais promissores numa intervenção de saúde pública.

Uma ampla gama de variáveis estava correlacionada ao parto numa instituição de saúde pública, mas a IA causal identificou as causas diretas. Para nossa surpresa, e contrariando o senso comum, a proximidade da gestante a uma instituição de saúde não era uma dessas causas – mas o acesso ao transporte era. Isso sugeriu que o governo deveria solucionar questões relacionadas ao transporte, em vez de construir mais instituições de saúde em locais próximos às famílias. Também ficamos surpresos em descobrir que a percepção de que o parto em hospital é mais seguro que o parto em casa era muito mais importante que crenças relacionadas à limpeza dos hospitais ou às competências ou problemas das equipes médicas. A probabilidade de parto institucional também era maior entre mães que tinham planos de parto e sabiam da existência de incentivos financeiros, o que validava o impacto do programa de incentivos do governo. Agora as descobertas desse estudo estão sendo usadas para criar cenários hipotéticos e balizar uma intervenção na qual profissionais na linha de frente da saúde ajudam mães em Uttar Pradesh a criar planos de parto detalhados com antecedência, incluindo o local do parto, como chegar lá e como arcar com custos extras.

Sete Recomendações de Escala

A IA está sendo adotada por empresas e governos que querem aprimorar processos, resolver problemas e aumentar a eficiência. É igualmente importante que as pessoas que lidam com questões de saúde e desenvolvimento estudem e apliquem a IA causal em maior escala. Essa tecnologia possui vantagens claras em relação à IA puramente preditiva. Os modelos preditivos conseguem gerar informações poderosas e, em muitos casos, precisas, sendo capazes de identificar, por exemplo, se o resultado de uma mamografia pode indicar câncer de mama. Mas a IA causal tem condições de detectar as causas subjacentes a um comportamento ou evento e de fornecer dados cruciais, coisa que os modelos preditivos não conseguem fazer, e isso pode levar a intervenções mais eficazes que gerem resultados positivos. Além disso, a IA causal não opera dentro de uma caixa-preta e, por isso, permite que pesquisadores testem o raciocínio por trás do modelo em questão, reduzindo o risco de distorções como as descritas anteriormente.

A IA causal identifica as causas subjacentes a um comportamento ou evento, fornecendo dados cruciais, o que os modelos preditivos não conseguem fazer.

Três fatores convergentes indicam que chegou a hora da inteligência artificial causal. Em primeiro lugar, avanços no campo da IA estão demonstrando as diversas aplicações de métodos causais e, com o aprimoramento dos modelos, sua adoção em maior escala e sua aplicação a novas situações, seu valor e suas limitações ficam mais claros. Em segundo lugar, a disponibilidade de conjuntos de dados em larga escala é cada vez maior. Assim como uma TV 4K de altíssima definição tem mais pixels por centímetro quadrado de tela que uma TV antiga de definição comum, maiores quantidades de dados geram previsões mais claras e precisas, aumentando a confiança nas descobertas realizadas por meio das redes causais. E, por fim, os setores de saúde e desenvolvimento estão investindo cada vez mais em políticas de precisão – isto é, em intervenções que gerem os melhores resultados possíveis, o que permite o emprego de recursos limitados naquilo que surtirá mais efeito. A IA causal é a ferramenta ideal para enfrentar esse desafio.

O caminho para o sucesso desses métodos requer trabalho. A seguir estão sete recomendações que podem facilitar a adoção e o uso da IA causal.

Aprimorar o uso e a qualidade dos dados | Na década passada, foram realizados investimentos em diversas iniciativas de coleta de dados em larga escala. Contudo, esses conjuntos de dados são em muitos casos subutilizados e poderiam ser mais bem explorados para extrair mais descobertas. Embora a disponibilidade de dados esteja crescendo, ainda há outros desafios. Muitos conjuntos de dados são fragmentados e apresentam variações qualitativas. A junção de diferentes conjuntos de dados também é um desafio – como, por exemplo, quando um conjunto contém informações em nível individual e outro, em nível regional ou nacional. A adoção de indicadores comuns em todas as iniciativas de coleta de dados num mesmo país ajudaria a extrair o máximo possível dos conjuntos de dados após sua junção.

Coletar dados mais abrangentes | A aplicação bem-sucedida da IA causal exige que sejam compreendidas todas as variáveis que podem afetar comportamentos – fatores estruturais, como políticas e leis, bem como crenças individuais, motivações, distorções e influências. O excesso de pressuposições acerca da importância ou não dos dados a serem coletados pode fazer com que se percam de vista as variáveis causais que são de fato responsáveis pelos comportamentos ou eventos, o que por sua vez pode levar ao estabelecimento de relações causais equivocadas.

Desenvolver ferramentas open source de alto desempenho para a aplicação de algoritmos de IA causal e que possam ganhar escala | Plataformas algorítmicas próprias são caras e, por isso, frequentemente inacessíveis nos setores de saúde e desenvolvimento. Softwares open source (ou de código-fonte aberto) são gratuitos, mais acessíveis e de melhor qualidade no longo prazo, já que mais pessoas podem analisar seus códigos-fontes e contribuir para seu aperfeiçoamento. Alguns algoritmos open source (como o bnlearn) já existem, porém precisam melhorar em termos de precisão e velocidade. Usuários não especializados em IA causal precisam saber que passos devem seguir para aplicar esse método em suas áreas. A Surgo Foundation está desenvolvendo ferramentas para reduzir as barreiras ao acesso e ajudar organizações que recém-adotaram a IA causal a evitar armadilhas em seus processos. Um exemplo é uma ferramenta open source que avalia se um determinado conjunto de dados se presta à aplicação de redes bayesianas e quais os algoritmos mais recomendados. A Surgo também está desenvolvendo um guia de trabalho para ajudar na transição da IA causal da pesquisa acadêmica para o uso prático em campo.

Mesclar inteligência artificial e inteligência humana | Uma estratégia baseada somente em dados não é capaz de resolver problemas de desenvolvimento sozinha. É necessário conhecimento especializado durante todo o processo para garantir que pesquisadores e desenvolvedores interpretem corretamente as redes causais. Especialistas podem melhorar o desempenho da IA causal incorporando limitações que refletem seu conhecimento prático sobre o funcionamento real dos sistemas e identificando a ausência de variáveis de confusão conhecidas nos dados. E à medida que a IA causal for mais utilizada, especialistas em ética e em políticas desempenharão papéis importantes, garantindo que o método evite a armadilha das distorções ou imprecisões verificadas em algumas aplicações de modelos de IA preditiva.

Aprimorar as formas de avaliação do desempenho dos algoritmos | Cientistas da computação estão pesquisando maneiras de aumentar a precisão e a robustez geral dos algoritmos de IA causal. Uma forma típica de se avaliar a precisão dos modelos causais é comparar seus resultados a relações causais conhecidas. Mas o que um pesquisador deve fazer caso não existam relações causais conhecidas para validar um modelo? (Afinal, em geral, o objetivo da IA causal é justamente descobrir essas relações.) E se os resultados de um modelo de IA causal contradisserem o conhecimento especializado existente? Uma solução pode ser a geração de conjuntos de dados artificiais com características semelhantes às de um conjunto de dados real, porém com relações causais predeterminadas entre suas variáveis. A avaliação do desempenho de um modelo de IA causal com um conjunto de dados artificial pode ajudar os pesquisadores a inferir a performance esperada num conjunto de dados real com características semelhantes.

Demonstrar o valor da IA causal no setor de desenvolvimento | Os exemplos citados acima são poderosos, porém raros. Uma maior divulgação do trabalho que está sendo realizado vai ajudar na adoção dos métodos causais. A Surgo Foundation está usando a IA causal para descobrir como otimizar o desempenho de profissionais de linha de frente na saúde, como decidir que intervenções devem ter sua escala ampliada para aprimorar o aprendizado dos estudantes e como aumentar a adoção de métodos modernos de planejamento familiar. Com o progresso da fundação, a aplicação da IA causal deverá ser testada em áreas como agricultura e mudanças climáticas.

Aprimorar a divulgação e o conhecimento entre os principais entes envolvidos | A IA causal ainda é um conceito muito novo para quem não é da área. É preciso que seu potencial seja explicado a formuladores de políticas e financiadores, gestores de programas e especialistas em monitoração e avaliação nos muitos setores nos quais a IA causal pode ser aplicada, para que eles entendam esses métodos, ao menos do ponto de vista conceitual.

O Próximo Passo Lógico

Para entender o mundo, os seres humanos observam e analisam padrões que se repetem. Já evoluímos muito, da criação de mitologias para explicar o clima à coleta de dados e a utilização de modelos matemáticos rigorosos para prever a próxima chuva ou a trajetória do próximo furacão. Porém, estamos sempre nos deparando com os limites daquilo que somos capazes de observar e dos métodos de que dispomos para analisar os dados que obtemos.

A inteligência artificial causal é o próximo passo lógico, viabilizado pelas transformações tecnológicas recentes e pela disponibilidade cada vez maior dos dados. Sua vantagem sobre algumas outras disciplinas das ciências sociais – e mesmo sobre a IA preditiva – é sua capacidade de identificar os fatores causais exatos que levam diretamente a determinados comportamentos ou resultados e de testar com eficácia diferentes métodos para alterar esses comportamentos ou resultados. Essa vantagem permite que pesquisadores e usuários se concentrem na melhor combinação de intervenções para enfrentar algumas das questões mais críticas da atualidade, das mudanças climáticas à saúde. Melhores inferências causais ajudarão os programas a fazer mais com menos recursos e em menos tempo. E integrando a IA causal e o conhecimento humano, esses programas poderão evitar os erros que ocorrem quando as pessoas – ou as máquinas ou softwares que elas criam – ignoram contextos essenciais ou caem na armadilha de confundir correlação com causalidade.

Em última instância, descobrir o “porquê” por trás de problemas complexos nos ajuda a entender como o mundo funciona de fato e, assim, a identificar as ações corretas para alcançar os resultados desejados. Ainda poderemos concluir que cem gramas de IA causal valem mais que um quilo de previsões.

Leia também: “O problema com a IA somos nós”