Em 1985, Richard Feynman, Prêmio Nobel de Física, proferiu uma palestra na qual debateu temas críticos no campo da inteligência artificial (IA).1 O diálogo do renomado físico teórico estadunidense com o público começou com uma pergunta-chave: “Você acha que haverá uma máquina que pode pensar como os humanos e ser mais inteligente do que os humanos?”. Para Feynman, as máquinas não pensariam como os seres humanos, assim como um avião não voa como os pássaros. Aviões não batem asas; são processos, dispositivos e materiais distintos. É um equívoco supor que a eficiência plena da IA será alcançada apenas quando for possível replicar exatamente a maneira como nós, humanos, raciocinamos e funcionamos. Sistemas maquínicos não precisam nos copiar para gerar valor. Veículos autônomos ilustram essa distinção: pelo menos até agora, nenhuma montadora colocou um robô no banco do motorista pretendendo imitar os humanos. Em 2016, o sistema de IA AlphaGo derrotou o campeão mundial de Go, Lee Sedol, com jogadas inéditas, ou seja, jogadas que nunca tinham sido feitas por um jogador humano. A IA se comporta frequentemente de maneiras que divergem da cognição humana.

O termo “inteligência artificial”, cunhado em 1956 no evento que constituiu a IA como campo de conhecimento e que universalmente designa a tecnologia, induz a comparações com a inteligência biológica, gerando mais confusão do que clareza. John McCarthy, o professor da Faculdade de Dartmouth, nos Estados Unidos, que organizou o evento, inicialmente referiu-se a “estudos de autômatos” para descrever a busca por máquinas capazes de comportamento automático; como não atraiu muita atenção, optou por inteligência artificial, que ao permitir antropomorfizações, tornou o campo mais atraente. A indústria, pressionada pela intensa competição, explora essa ambiguidade para aumentar o engajamento dos usuários. Os sistemas atuais de IA são restritos a propósitos definidos pelos desenvolvedores e não alcançam a complexidade e a adaptabilidade do cérebro humano, aquilo que conhecemos como “neuroplasticidade”.

O raciocínio é uma habilidade crucial que diferencia a IA da cognição humana, ou do que chamamos de “pensamento”. Pesquisadores da Universidade Cornell, nos Estados Unidos, estimam que tomamos cerca de 226 decisões por dia apenas sobre alimentação, e à medida que o nível de responsabilidade aumenta, também se eleva a multiplicidade de escolhas que precisamos fazer: um adulto médio chega a 35 mil decisões remotamente conscientes por dia.2 Toda decisão envolve raciocínio, um atributo central da inteligência humana.

As redes neurais – base de modelos de linguagem como ChatGPT da OpenAI, Gemini do Google, Llama da Meta, Claude da Anthropic, DeepSeek R1 – são relativamente eficientes em reconhecer padrões em grandes volumes de dados, mas não emulam o raciocínio humano. Este envolve método de busca (search), formulação de hipóteses, avaliação de cenários e causalidade, elementos ausentes em redes probabilísticas, como as redes neurais. Ao estabelecer apenas correlações, essas redes não contemplam causalidade (teia de relações de causa e efeito) nem contrafactual (situação ou evento que não aconteceu, mas poderia ter acontecido), que são parte intrínseca dos métodos de search, que por sua vez são parte intrínseca do raciocínio humano (o “aprendizado” das redes neurais ocorre durante o treinamento, e esses sistemas não são capazes de responder a perguntas que quebram as regras em que foram treinados).

Judea Pearl é um cientista da computação e filósofo israelense-estadunidense, ganhador do Prêmio Turing de 2011 – o mesmo outorgado a Geoffrey Hinton, Yoshua Bengio e Yann LeCun em 2018. No final dos anos 1980, Pearl identificou a falta de raciocínio causal como o maior obstáculo para a IA atingir a inteligência humana. “Um módulo de raciocínio causal permitiria às máquinas refletir sobre seus erros, identificar pontos fracos em seu software, funcionar como entidades morais e dialogar sobre suas próprias escolhas e intenções”, argumenta. Ele destaca a capacidade humana de imaginar cenários alternativos, essencial para o planejamento. “Assim, se quisermos que os robôs respondam ‘por quê?’ ou mesmo entender os significados, devemos equipá-los com um modelo causal e ensiná-los a responder à perguntas contrafactuais”, conclui Pearl.3

Extrair informações úteis dos dados é um processo limitado; os dados são capazes, por exemplo, de aferir que os pacientes que tomaram um determinado medicamento se recuperaram mais rápido do que aqueles que não o tomaram, mas os dados não nos dizem a causa. Pearl destaca no raciocínio humano a capacidade de refletir sobre as próprias ações passadas e vislumbrar cenários alternativos (base do raciocínio). Para executar uma tarefa com algum grau de complexidade e/ou relevância, os humanos recorrem ao planejamento, imaginando e comparando as possibilidades e consequências de distintas estratégias. Pearl denomina esse processo de “modelo mental da realidade”, no qual “a imaginação acontece, nos permite experimentar diferentes cenários implementando alterações localizadas no modelo”. Para o cientista, “a capacidade de conceber a própria intenção e, em seguida, usá-la como uma evidência no raciocínio causal é um nível de autoconsciência (se não consciência) que nenhuma máquina que eu conheça alcançou. […] enquanto as probabilidades codificam nossas crenças sobre um mundo estático, a causalidade nos diz se e como as probabilidades mudam quando o mundo muda, seja por intervenção ou por ato de imaginação. Sem a capacidade de vislumbrar realidades alternativas e compará-las com a realidade atualmente existente, uma máquina não pode responder à pergunta mais básica que nos torna humanos: ‘Por quê?’”.

Os algoritmos de IA identificam padrões estatísticos, mas não têm como saber o que esses padrões significam porque estão confinados ao mathworld (mundo da matemática); sem compreender o mundo real, a IA não tem como avaliar se os padrões estatísticos que encontram são coincidências úteis ou sem sentido. Como alertam alguns especialistas, o perigo atual não é a IA superar a inteligência humana, mas a suposição equivocada de que ela o faz, levando à delegação irrefletida de decisões críticas. A IA deve ser parceira, não substituta, de especialistas humanos.

Como alertam alguns especialistas, o perigo atual não é a IA superar a inteligência humana, mas a suposição equivocada de que ela o faz, levando à delegação irrefletida de decisões críticas. A IA deve ser parceira, não substituta, de especialistas humanos

A transparência domina o debate sobre inteligência artificial e integra a lista das principais críticas às decisões automatizadas, mas humanos e organizações também são opacos. São múltiplas as razões. No primeiro caso, participam do processo decisório a intuição, o inconsciente, as emoções, os instintos – a exposição da vida privada nas redes sociais não significa, necessariamente, transparência. No segundo, a transparência é limitada pelo sigilo comercial e industrial. Nem sempre a transparência é considerada um atributo positivo. O filósofo sul-coreano Byung-Chul Han, por exemplo, em Sociedade da transparência, critica a transparência como uniformizadora, eliminando ambiguidades e complexidades. Para ele, a linguagem transparente é formal, puramente mecânica, operacional, e elimina toda ambivalência, todas as relações assimétricas: “o imperativo expositivo leva a uma absolutização do visível e do exterior, o invisível não existe, pois não possui valor expositivo algum, não chama atenção”.

No caso da inteligência artificial, a transparência tem valor positivo, especialmente na interpretação dos resultados gerados pelos sistemas habilitados por IA. No entanto, é importante diferenciar a cadeia de produção de um sistema de IA e o uso específico da IA: a cadeia de produção é permeada pela subjetividade humana nas decisões em cada etapa, portanto, a transparência é factível (explicação sobre cada decisão humana); a transparência no uso da técnica de redes neurais profundas é mais complicada – os algoritmos estabelecem correlações e geram uma hierarquia de pesos entre as correlações, processo, não à toa, denominado black box (ou opacidade da técnica, ou ainda não interpretabilidade).

Em busca de uma definição

A complexidade da IA transcende a natureza da técnica, começa pela dificuldade de conceituar “inteligência artificial”. Definir a IA com precisão talvez não seja essencial para desenvolvedores, mas é mandatório para reguladores, legisladores, gestores e cientistas sociais. As iniciativas mundo afora de estabelecer arcabouços regulatórios enfrentam o desafio de delimitar o que é ou o que não é IA, condição básica para gerar diretrizes e leis aplicáveis em processos de arbitragem por juízes.

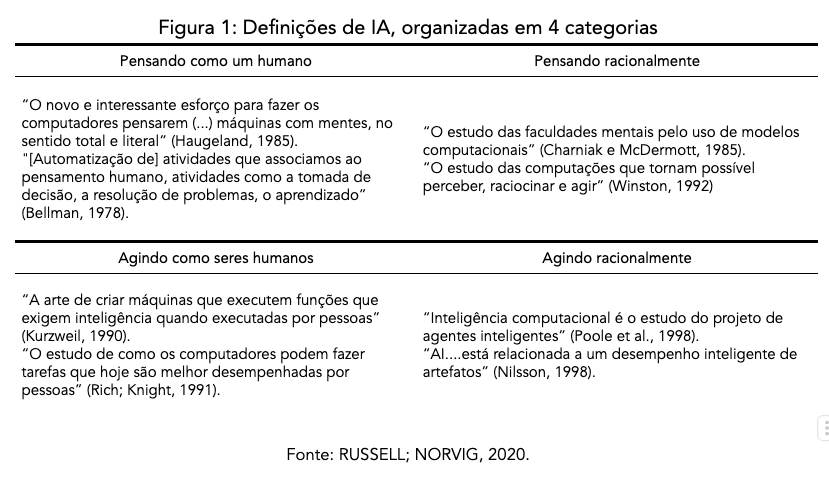

O britânico Stuart Russell e o estadunidense Peter Norvig, autores de Inteligência artificial, descrevem a IA como o estudo de agentes que percebem e agem no ambiente. Considerando os vários domínios de implementação, esses cientistas da computação identificam oito definições agregadas em duas dimensões: as relacionadas a processos de pensamento e raciocínio, e as relacionadas a comportamento (veja o quadro).

Russell e Norvig, contudo, reconhecem a dificuldade de unificar as definições de inteligência artificial pela diversidade de aplicações nos vários subcampos. É perceptível a amplitude conceitual das definições listadas, inclusive o fato de algumas delas definirem a IA a partir do conceito não universal de “inteligência”. Para os autores, o entendimento de como o ser humano pensa é precondição para qualquer estratégia de modelagem cognitiva, o que significa penetrar na mente humana (não por coincidência, os campos da IA e da ciência cognitiva evoluem interconectados).

DEFINIÇÕES DE IA, ORGANIZADAS EM 4 CATEGORIAS

As oito definições de IA estão dispostas ao longo de duas dimensões. As que estão na parte superior da tabela se relacionam a processos de pensamento e raciocínio, enquanto as definições da parte inferior se referem a comportamento. As do lado esquerdo medem o sucesso em termos de fidelidade ao desempenho humano, enquanto as do lado direito medem o sucesso comparando-o a um conceito ideal de inteligência, chamado racionalidade. Um sistema é racional se “faz a coisa certa”, dado o que ele sabe.

A Organização para a Cooperação e Desenvolvimento Econômico (OCDE)4 define a IA como sistema baseado em máquina capaz de influenciar o ambiente produzindo uma saída (previsões, recomendações ou decisões) para um determinado conjunto de objetivos. Ele usa dados e entradas baseados em máquinas e/ou humanos para a) perceber ambientes reais e/ou virtuais; b) abstrair essas percepções em modelos por meio de análise de maneira automatizada (por exemplo, com aprendizado de máquina) ou manualmente; e c) usar inferências em modelos para formular opções de resultados. Os sistemas de IA são projetados para operar com vários níveis de autonomia. A Lei de IA europeia (AI Act), no Anexo I da AI Act5, fornece três conceituações de IA: (a) abordagens de aprendizado de máquina, incluindo aprendizado supervisionado, não supervisionado e por reforço, usando uma ampla variedade de métodos, incluindo aprendizado profundo; (b) abordagens baseadas em lógica e conhecimento, incluindo representação de conhecimento, programação indutiva (lógica), bases de conhecimento, mecanismos de inferência e dedução, raciocínio (simbólico) e sistemas especializados; (c) abordagens estatísticas, estimação bayesiana, métodos de busca e otimização. As definições de IA são controversas, inclusive porque os termos “abordagens estatísticas” e “métodos de busca e otimização” incluídos na última definição são tão amplos que podem envolver sistemas normalmente não associados à IA. Reconhecendo a dificuldade, a Comissão Europeia optou como solução listar as possibilidades de aplicação em cada categoria.

A House of Lords (câmara alta do Parlamento do Reino Unido)6, por sua vez, admite a inexistência de uma definição universalmente aceita de inteligência artificial, ponderando sobre a urgência de um estudo específico sobre o que é e o que não é IA. Para fins práticos, adotou-se a definição do governo inglês expressa no “Livro Branco de Estratégia Industrial”7 – “Tecnologias com a capacidade de executar tarefas que, de outra forma, exigiriam inteligência humana, como percepção visual, reconhecimento de fala e tradução de idiomas” –, acrescentando a essa definição a capacidade dos sistemas atuais de IA de aprender ou se adaptar a novas experiências ou estímulos.8 Definição igualmente generalista, que não abarca o amplo espectro de uso atual da inteligência artificial.

Essa diversidade de definições está presente também nos institutos. Para o Human-Centered Artificial Intelligence (HAI) da Universidade Stanford9, a inteligência artificial pode ser definida como a capacidade de aprender e executar uma variedade de técnicas para resolver problemas e atingir objetivos – técnicas que são apropriadas ao contexto em um mundo incerto e em constante variação –, ressalvando, contudo, que a autonomia na IA não tem o sentido de autogoverno comum na política ou na biologia. O Alan Turing Institute10 define a IA como máquinas que agem de forma inteligente, normalmente fazendo previsões ou decisões sobre vários aspectos do mundo em que vivemos. Usada, geralmente, em sistemas baseados em aprendizado de máquina (machine learning), técnica que exige grandes volumes de dados de “treinamento” para serem eficazes, e apresentam resultados mais assertivos quando os dados são cuidadosamente rotulados (“aprendizado supervisionado”).11

A democracia prospera com o dissenso, mas depende de um terreno compartilhado de fatos. Quando sistemas algorítmicos criam ambientes informacionais tão distintos que cidadãos não concordam sequer sobre a natureza dos problemas sociais, o processo deliberativo fica comprometido

Entre os autores, o estadunidense Ian Goodfellow e os canadenses Yoshua Bengio e Aaron Courville, em Deep learning (Aprendizagem profunda, em tradução livre), consideram a inteligência artificial como um campo próspero com muitas aplicações práticas e tópicos de pesquisa ativos, constituído de software inteligente para automatizar o trabalho de rotina, entender fala ou imagem, produzir diagnósticos médicos e apoiar pesquisas científicas básicas. Para eles, o verdadeiro desafio é resolver tarefas de fácil realização pelos humanos, mas difíceis de ser descritas formalmente – problemas intuitivos como reconhecer palavras faladas ou rostos em imagens. Já o cientista da computação turco Ethem Alpaydin considera a inteligência artificial, inspirada no cérebro biológico, parte da ciência da computação e, como em qualquer ramo da engenharia, o objetivo é construir sistemas úteis. A incapacidade do ser humano de explicar a si próprio inviabiliza a tarefa de escrever um programa de computador que reproduza o funcionamento dos seres humanos. No livro Machine learning (Aprendizado de máquina, em tradução livre), o autor diferencia um programa de aprendizado de máquina de um programa de computador comum pelo fato de os parâmetros do primeiro serem modificáveis; ao atribuir valores diferentes a esses parâmetros, o programa pode fazer coisas distintas alterando os resultados. Segundo o filósofo belga Mark Coeckelbergh, em Ética na inteligência artificial, a AI pode ser definida como inteligência exibida ou simulada por código (algoritmos) ou máquinas, mas admite que essa definição é baseada no conceito filosoficamente vago de “inteligência”. Inicialmente, Coeckelbergh recorre à definição de Philips Jansen – “a ciência e a engenharia de máquinas com capacidades que são consideradas inteligentes pelo padrão da inteligência humana” –, mas reconhece sua limitação ao considerar a “inteligência” necessariamente como semelhante à humana. A cientista da computação estadunidense Melanie Mitchell, em Artificial intelligence: a guide for thinking humans (Inteligência artificial: um guia para humanos pensantes, em tradução livre), cita a definição de um comitê de pesquisadores proeminentes: “um ramo da ciência da computação que estuda as propriedades da inteligência sintetizando a inteligência”, ou seja, reproduzindo a inteligência humana. Esse mesmo comitê, segundo a autora, admite o desafio de definir a IA, mas considera essa limitação como positiva. A pesquisadora britânica Margaret A. Boden, em Inteligência artificial: uma brevíssima introdução, pondera que a IA procura preparar os computadores para fazer coisas que a mente é capaz de fazer, sendo que algumas dessas coisas (como o raciocínio) são definidas normalmente como “inteligentes”.

Nas definições de IA listadas é possível identificar como elementos comuns: a) o caráter generalista; b) a tênue linha de diferenciação entre modelos estatísticos com ou sem o uso de técnicas de IA, inclusive citando termos e técnicas estatísticas associados igualmente a sistemas com ou sem IA; c) a prerrogativa de listar possibilidades de aplicação em diversos domínios e/ou categorias de risco; e d) conceituam a IA com base no termo “inteligência”, conceito não universal. Com base no cenário atual e nas propriedades da tecnologia, parece ser mais apropriado definir a IA pela natureza da tarefa a ser executada, e não pela técnica utilizada, ou seja, seria inteligência artificial quando o sistema substitui ações que requerem decisão humana, em geral, que acessam a “inteligência” em qualquer que seja sua compreensão.

Entre utopias e distopias sobre a inteligência artificial, destacam-se o risco existencial e o impacto na democracia.

O que é, afinal, inteligência artificial?

A resposta depende de quem responde. Conceito multifacetado, a IA já foi definida como imitação da mente humana, como lógica estatística, como agente racional ou como qualquer sistema que automatize decisões. O termo foi cunhado em 1956 por John McCarthy durante a conferência de Dartmouth e substituiu “estudos de autômatos” por soar mais atrativo. A seguir, 13 definições distintas.

- Stuart Russell e Peter Norvig | No livro Inteligência artificial, organizam as definições de IA em quatro categorias: pensar como humanos, pensar racionalmente, agir como humanos e agir racionalmente. A dupla vê a IA como o estudo de agentes que recebem percepções do ambiente e executam ações.

- OCDE | Define IA como sistema baseado em máquina que produz saídas (previsões, decisões) com diferentes níveis de autonomia, a partir de entradas humanas ou automatizadas.

- AI Act – União Europeia | Traz definição funcional de IA com três abordagens técnicas: aprendizado de máquina; lógica e conhecimento; e estatística e otimização.

- Governo Britânico – Livro Branco de Estratégia Industrial | Define IA como tecnologia capaz de realizar tarefas que exigem inteligência humana, como visão e linguagem, com capacidade de adaptação a novos estímulos.

- House of Lords – Parlamento Britânico | Adota a definição do governo britânico e ressalta a falta de consenso sobre o conceito de IA.

- Stanford HAI – Human-Centered Artificial Intelligence | Define IA como a capacidade de aplicar técnicas adequadas a contextos variáveis e incertos, deixando claro que “autonomia” aqui não é autogoverno.

- Alan Turing Institute | IA são máquinas que fazem previsões ou decisões com base em dados, geralmente usando aprendizado de máquina supervisionado.

- Ian Goodfellow, Yoshua Bengio e Aaron Courville | Descrevem a IA como campo de software inteligente voltado à automatização de tarefas humanas complexas.

- Ethem Alpaydin | Descreve a IA como parte da ciência da computação, com programas que ajustam automaticamente seus parâmetros para melhorar seu desempenho.

- Mark Coeckelbergh | Define IA como inteligência exibida ou simulada por código ou máquinas, reconhecendo que o termo “inteligência” é filosoficamente vago.

- Philips Jansen et al. (2018), citados por Coeckelbergh | “A ciência e a engenharia de máquinas com capacidades que são consideradas inteligentes pelo padrão da inteligência humana.”

- Melanie Mitchell | IA é “um ramo da ciência da computação que estuda as propriedades da inteligência sintetizando a inteligência”, com foco em reproduzir a inteligência humana.

- Margaret A. Boden | A IA busca preparar computadores para realizar tarefas que normalmente exigem capacidades mentais humanas, como o raciocínio.

Apesar da diversidade de abordagens, a maioria das definições de inteligência artificial apresenta alguns pontos em comum: são generalistas e imprecisas; utilizam termos compartilhados com modelos estatísticos tradicionais; focam mais nas aplicações ou riscos do que em descrever a tecnologia; baseiam-se no conceito de “inteligência”, que é subjetivo e controverso.

A ameaça do risco existencial

O “Risco Existencial” foi revisitado com o advento do ChatGPT. O célebre cientista britânico Alan Turing, em seu artigo seminal de 1950,12 alertou para a possibilidade de as máquinas nos ultrapassarem em poder intelectual. Consta como sua última aparição pública uma entrevista concedida à BBC em 1952, na qual afirmou: “Embora [o computador digital] possa ser programado para se comportar como cérebros, no momento não sabemos como isso deve ser feito. Com essa perspectiva, estou totalmente de acordo. Deixo em aberto a questão de saber se teremos ou não teremos sucesso em encontrar tal programa. Eu, pessoalmente, estou inclinado a acreditar que tal programa será encontrado”. Aparentemente, Turing não associou sua previsão otimista a um risco existencial.

O filósofo sueco Nick Bostrom, em Superinteligência, define “risco existencial” como aquele que ameaça aniquilar a vida inteligente no planeta Terra, ou limitar permanente e drasticamente seu potencial. Para Bostrom, o primeiro risco existencial criado pelo ser humano foi a bomba atômica, a partir da preocupação de que a explosão inicial geraria uma reação em cadeia descontrolada, o que efetivamente não aconteceu nos bombardeios dos Estados Unidos em Hiroshima e Nagasaki, no Japão, ao final da Segunda Guerra Mundial, em agosto de 1945. O segundo risco existencial é a potencial explosão da inteligência com a criação da superinteligência de máquina, detentora da vantagem estratégica de moldar o futuro da vida inteligente com base em suas próprias motivações. A superinteligência visualizaria os humanos como uma ameaça potencial ao seu sistema, devendo portanto ser eliminados, causando uma “catástrofe existencial”.

Para o filósofo australiano Toby Ord, no livro The precipice: existencial risk and the future of humanity (O precipício: risco existencial e o futuro da humanidade, em tradução livre) – no qual, inclusive, cita Bostrom –, riscos existenciais são aqueles que ameaçam de destruição o potencial de longo prazo da humanidade, considerando que a extinção é a maneira mais óbvia de destruir todo esse potencial. Existem outras, argumenta o autor, como, por exemplo, se a civilização humana sofrer um colapso irrecuperável, isso pode igualmente aniquilar o potencial de longo prazo da humanidade. Ord qualifica “potencial de longo prazo da humanidade” como “o conjunto de todos os futuros possíveis que permanecem abertos para nós. Esta é uma ideia expansiva de possibilidade, incluindo tudo o que a humanidade poderia eventualmente alcançar, mesmo que ainda não tenhamos inventado os meios de alcançá-lo”. Ele enquadra os riscos existenciais em três grandes categorias: os riscos naturais, riscos antropogênicos (originados pela atividade humana, como armas nucleares, mudanças climáticas, degradação ambiental) e riscos futuros (pandemias, inteligência artificial). Ord fundamenta a inclusão da IA nos riscos existenciais com base em uma pesquisa realizada em 2016 entre os participantes das conferências NeurIPS e ICML: dos 21% que responderam à pesquisa, 50% creem no advento da inteligência geral artificial (AGI) em 45 anos (a previsão dos pesquisadores estadunidenses para essa tecnologia hipotética que pode estar preparada para revolucionar quase todos os aspectos da vida e do trabalho humanos é 74 anos). Além de as previsões de longo prazo estarem mais para ficção, ele próprio admite a fragilidade da pesquisa (o que a leitura atenta do relatório da pesquisa confirma).

A inteligência artificial como risco existencial, descrita pelos autores acima, não se refere aos sistemas de IA atuais, mas a uma especulação sobre o futuro da IA em que a inteligência de máquina alcança ou supera as capacidades da inteligência humana (superinteligência). Com mais incertezas do que certezas, não existem evidências científicas de que o desenvolvimento da IA será exitoso em atingir esses limiares, contudo as especulações sobre um futuro distópico encontram respaldo no imaginário popular moldado pela ficção científica e pelo medo de uma tecnologia poderosa e obscura.

Em 1967, o cientista cognitivo estadunidense Marvin Minksy, um dos fundadores em 1956 do campo da inteligência artificial, fez uma previsão ousada: “Dentro de uma geração, o desafio de criar ‘inteligência artificial’ será substancialmente resolvido”. Quase duas gerações depois, quão perto estamos do objetivo de dotar as máquinas de inteligência de nível humano ou superior (superinteligência)? Segundo Judea Pearl, não sabemos: “Estamos de fato chegando mais perto do dia em que computadores ou robôs poderão entender conversas causais? Podemos criar inteligências artificiais com tanta imaginação quanto um ser humano de 3 anos? Eu compartilho algumas ideias, mas não dou conclusões definitivas. […] Tal máquina seria uma companhia maravilhosa para nossa espécie e realmente se qualificaria como o primeiro e melhor presente da IA para a humanidade”.

O impacto na democracia

Na democracia, a IA é ambivalente. Se, por um lado, pode potencializar processos participativos ampliando o engajamento, conectar cidadãos e governantes, por outro representa riscos ao facilitar a disseminação de desinformação, amplificar polarizações e intensificar vigilância massiva, além de fomentar estereótipos de identidade. Essa ambivalência ganha relevância em um contexto global de fragilização das democracias: o Índice de Democracia (Democracy Index) mostra que 45,4% da população mundial vive em regimes democráticos, sendo que apenas 7,8% desfrutam de uma democracia plena, enquanto 39,4% estão sob regimes autoritários. O Parlamento Europeu, em seu relatório “Artificial intelligence, democracy and elections” de 2023, reconhece a IA como uma oportunidade para aprimorar o processo democrático, ao contribuir para uma melhor compreensão da política pelos cidadãos, e para aproximar os políticos dos eleitores de modo mais eficaz, consequentemente mudando a qualidade das campanhas eleitorais e das formulações de políticas públicas. No entanto, o relatório ressalta que os benefícios da IA para a democracia dependem de salvaguardas robustas, como técnicas para detectar o uso de conteúdo gerado por IA.

A IA generativa, capaz de produzir textos, imagens e vídeos hiper-realistas, está abalando três pilares democráticos essenciais: representação, responsabilização e confiança. Se antes já era difícil separar fato de ficção, agora ficou pior. A proliferação de deepfakes e narrativas manipuladoras mina a confiança na informação, consequentemente a credibilidade das instituições. Essa preocupação aumentou com o recente desmantelamento da mediação independente de conteúdo pelas plataformas sociais. Os pesquisadores estadunidenses Sarah Kreps e Doug Kriner, em How AI threatens democracy (Como a IA ameaça a democracia, em tradução livre), argumentam que “a confiança social é uma cola essencial que mantém unidas as sociedades democráticas, o ‘adesivo’ que sustenta as democracias; sua erosão enfraquece o engajamento político e a adesão a normas democráticas”. Quando esse adesivo se dissolve, o resultado é a apatia ou a radicalização.

A polarização, é claro, não nasceu com a IA. Em Network propaganda: manipulation, disinformation, and radicalization in American politics (Propaganda de rede: manipulação, desinformação e radicalização na política americana, em tradução livre), os pesquisadores Yochai Benkler, Robert Faris e Hal Roberts mostram como a fragmentação midiática estadunidense precedeu a era digital. A IA, contudo, amplificou o problema ao criar microrrealidades personalizadas, transformando significativamente a esfera pública, em particular nas democracias avançadas. O relatório do Observatório da Informação e Democracia (OID) de janeiro de 2025 “Information ecosystems and troubled democracy13” revela que apenas 40% dos entrevistados confiam na mídia, com variações drásticas entre países: Finlândia teve a maior confiança geral, com 69%; Estados Unidos, 32%; França, 31%; Argentina, 30%; Grécia, 23%; Hungria, 23%. Quando algoritmos de IA alimentam cada usuário com uma versão diferente dos fatos, o próprio conceito de esfera pública desintegra-se, criando bolhas onde até a realidade é relativa.

O filósofo alemão Jürgen Habermas,14 teórico da “ação comunicativa”, acreditava que a democracia depende de uma esfera pública em que fatos são incontestáveis – mesmo que as opiniões divirjam. A esfera pública democrática garante o engajamento dos cidadãos em debates racionais sobre questões de interesse comum, e na qual todos têm igual oportunidade de expressar suas perspectivas. Habermas reconhece que esse ideal nunca foi plenamente concretizado, mas é um horizonte normativo para avaliar práticas democráticas.

A regulação da IA enfrenta o denominado “dilema de Collingridge”, um problema de duplo vínculo evidenciado pelo pesquisador britânico David Collingridge em 1980 no livro The social control of technology (O controle social da tecnologia, em tradução livre): os efeitos de uma tecnologia só se tornam evidentes quando ela já está amplamente desenvolvida e utilizada; e, quando já se encontra enraizada na sociedade, seu controle é difícil. Esse dilema reflete o “problema de ritmo”: a inovação tecnológica avança exponencialmente, enquanto os sistemas sociais, econômicos e legais evoluem de forma incremental. A União Europeia tentou contornar esse desafio com a Lei de Inteligência Artificial da Europa (AI Act), em vigor desde agosto de 2024, mas sua implementação esbarra em brechas e resistências políticas e de mercado; como resposta, a Comissão Europeia está tomando medidas para flexibilizar a lei, em especial aliviar o custo regulatório para pequenas e médias empresas.

Mais de três décadas depois de Collingridge, Mark Coeckelbergh15 salienta que a inteligência artificial não é apenas uma questão de tecnologia, mas também do que os humanos fazem com ela, como a usam, como a percebem e experimentam, e como a inserem em ambientes técnico-sociais. Desse modo, pensar sobre a ética, segundo o filósofo, significa pensar não somente no que precisa ser feito em relação à IA, mas igualmente a respeito de quem vai e deve decidir sobre o futuro da IA, portanto, sobre o futuro da sociedade. Em Why AI undermines democracy and what to do about it (Por que a IA mina a democracia e o que fazer a esse respeito, em tradução livre), ele argumenta que as tecnologias são políticas: não são meros instrumentos para atingir os objetivos humanos, mas mudam objetivos e significados, logo não são neutras em relação à democracia. O filósofo lista um conjunto de efeitos positivos e negativos da IA, com destaque para as assimetrias de poder. Não é a IA em si que é o problema, mas como é usada e integrada a outros sistemas humanos, podendo corroer democracias e fortalecer autoritarismos. Para Coeckelbergh, a fragmentação dos diálogos coletivos representa um desafio fundamental para sociedades democráticas. O problema não está na pluralidade de opiniões, mas na erosão das bases comuns necessárias para o diálogo democrático. A democracia prospera com o dissenso, mas depende de um terreno compartilhado de fatos. Quando sistemas algorítmicos criam ambientes informacionais tão distintos que cidadãos não concordam sequer sobre a natureza dos problemas sociais, o processo deliberativo fica comprometido. Coeckelbergh identifica mecanismos pelos quais a IA está erodindo o consenso democrático: direcionamento de mensagens específicas a subgrupos da população, favorecimento de conteúdo polarizador, geração de consensos artificiais no interior de bolhas e personalização não apenas do que vemos, mas do que consideramos verdade. Ele enfatiza que não precisamos de consenso sobre soluções políticas – o debate robusto é saudável –, mas sim da capacidade de reconhecer uma base factual compartilhada para articular divergências.

“O futuro da IA – a forma que essa tecnologia assume – está inextricavelmente ligado ao nosso futuro. A questão de como governar a IA, portanto, é, na verdade, uma questão de como garantir que tornemos nosso futuro melhor, e não pior”

Assim como os dados também não são neutros – são gerados, coletados, rotulados e estruturados por pessoas com vieses –, o processo de elaboração, desenvolvimento e treinamento de modelos de IA codificam padrões, valores, relações de poder. Sistemas são geralmente projetados em conformidade com interesses privados de maximização de lucro, nem sempre coincidentes com o interesse social. Portanto, os impactos da IA dependem de quem a controla e como é integrada à sociedade; pode reforçar autoritarismos ou otimizar serviços públicos e ampliar a participação cidadã. O desafio atual é garantir que a evolução da inteligência artificial preserve – e até fortaleça – os valores democráticos.

Na década de 1980, o historiador estadunidense Melvin Kranzberg16 contestou o determinismo tecnológico, afirmando que a tecnologia oferece oportunidades, mas a escolha do que fazer com elas permanece circunscrita à esfera humana. Isso o motivou a formular seis leis da tecnologia. A primeira formula que “a tecnologia não é boa nem má; nem é neutra”, ou seja, a interação da tecnologia com a ecologia social é de tal ordem que tem consequências ambientais, sociais e humanas que vão além de seus propósitos iniciais, e pode ter resultados distintos quando adotada em distintos contextos ou circunstâncias. Em sua quarta lei, ele destaca que embora a tecnologia seja primordial em questões públicas, fatores não técnicos têm precedência em decisões de política tecnológica.

A inteligência artificial pode ser um recurso valioso para a democracia ou um risco sem precedentes. O futuro dependerá de como a sociedade lidar com ela: se houver uma mobilização (governos, empresas, academia e cidadãos), a tecnologia poderá ajudar – e não destruir – a democracia. De qualquer forma, a democracia, em sua essência dinâmica, terá de se reinventar para sobreviver – e prosperar – na era da inteligência artificial.

O futuro da IA

Como toda tecnologia, a IA é social e humana, seus efeitos dependem do que nós, humanos, fazemos com ela, como a percebemos, como a experimentamos e usamos, como a inserimos nos ambientes técnico-sociais. Cabe à sociedade deliberar, entre inúmeras questões, sobre se a IA deve ser aplicada em todos os domínios e para executar todas as tarefas, e se justifica-se o uso de IA em aplicações de alto risco.

Karen Hao, no recém-lançado livro Empire of AI (O império da IA, em tradução livre), oferece uma boa síntese: “A IA é uma das tecnologias mais importantes desta era. Em pouco mais de uma década, reformulou a espinha dorsal da internet, tornando-se uma mediadora onipresente das atividades digitais. Em menos tempo ainda, está a caminho de reconectar muitas outras funções cruciais na sociedade, da saúde à educação, do direito às finanças, do jornalismo ao governo. O futuro da IA – a forma que essa tecnologia assume – está inextricavelmente ligado ao nosso futuro. A questão de como governar a IA, portanto, é, na verdade, uma questão de como garantir que tornemos nosso futuro melhor, e não pior”.

NOTAS

- Vídeo da palestra disponível em https://www.cantorsparadise.com/richard-feynman-on-artificial-general-intelligence-2c1b9d8aae31. Acesso em: 20 jul. 2025. ↩︎

- Referência: https://www.pbsnc.org/blogs/science/how-many-decisions-do-we-make-in-one-day ↩︎

- The book of why: the new science of cause and effect, de Judea Pearl, 2018. ↩︎

- OCDE. AI Policy Observatory. OCDE AI Principles overview. Disponível em: https://oecd.ai/en/ai-principles. Acesso em: 26 nov. 2022. ↩︎

- The AI Act – Annexes. Disponível em: https://artificialintelligenceact.eu/wp-content/uploads/2021/08/Annexes.pdf. Acesso em: 26 nov. 2022. ↩︎

- A Câmara dos Lordes é a câmara alta do Parlamento do Reino Unido. O Parlamento também inclui a Coroa britânica e a Câmara dos Comuns. A Câmara dos Lordes não tem um número determinado de membros, mas atualmente conta com 792 lordes. Disponível em: https://www.parliament.uk/business/lords/. Acesso em: 28 nov. 2022. Definição de IA disponível em: https://publications.parliament.uk/pa/ld201719/ldselect/ldai/100/10005.htm#_idTextAnchor006. Acesso em: 28 nov. 2022. ↩︎

- Department for Business, Energy and Industrial Strategy, Industrial Strategy: Building a Britain fit for the future (November 2017), p. 37. Disponível em: https://www.gov.uk/government/publications/industrial-strategy-building-a-britain-fit-for-the-future. Acesso em: 28 nov. 2022. ↩︎

- Artificial Intelligence Committee AI in the UK: ready, willing and able? Report of Session 2017-19 – published 16 April 2017 – HL Paper 100. Disponível em: https://publications.parliament.uk/pa/ld201719/ldselect/ldai/100/10002.htm. Acesso em: 2 dez. 2022. ↩︎

- Disponível em: https://hai.stanford.edu/. Acesso em: 3 dez. 2022. ↩︎

- Disponível em: https://www.turing.ac.uk/. Acesso em: 3 dez. 2022. ↩︎

- Disponível em: https://www.turing.ac.uk/news/what-does-ai-mean-turing. Acesso em: 2 dez. 2022. ↩︎

- Referência: “Computer Machinery and Intelligence”, revista Mind. https://philpapers.org/rec/TURCMA. ↩︎

- Disponível em: https://observatory.informationdemocracy.org/report/information-ecosystem-and-troubled-democracy/. As constatações decorrem de três painéis de avaliação de pesquisa compostos por mais de 60 pesquisadores voluntários, coordenados por seis relatores e liderados por um diretor científico, reunindo mais de 1,6 mil fontes. ↩︎

- Habermas, Jürgen, Sara Lennox, and Frank Lennox. ‘The Public Sphere: An Encyclopedia Article (1964)’. New German Critique, n. 3, p. 49-55, Autumn 1974. https://doi.org/10.2307/487737. ↩︎

- Coeckelbergh, M. (2020). AI Ethics (tradução para o português em novembro 2023, Ética na inteligência artificial, Ubu Editora). ↩︎

- Kranzberg, M. Tecnologia e História: “Leis de Kranzberg”. Tecnologia e Cultura, v. 27, n. 3, p. 544-560, 1968. https://doi.org/10.2307/3105385. ↩︎